14 Metrificação

Versão 0.1.0 - 20/12/2025

Qual será o tamanho da produção e da deposição informacional? E desta, qual seria a quantidade correspondente de lixo? Para isso, primeiro precisamos de uma maneira de medir informação, e em seguida tentar calcular as taxas de informação criada, armazenada e destruída.

Não há como medir “informação” sem antes defini-la. E nisso já incorre uma escolha com grandes consequências: uma opção por entender informação de uma maneira e não de outras. O problema é até maior: ao querer medir informação, já estamos incorrendo numa escolha que descarta formações intensas porém não exprimíveis numericamente, incluindo aí toda a polimorfia e polivalência do termo123, as potencialidades da forma recém formada assim como os múltiplos significados passíveis de interpretação numa mensagem. Imagine por exemplo uma mensagem com duplos, triplos, n-uplos sentidos… como quantificar a informação nela contida, especialmente se não sabemos a quantidade total de sentidos implícitos?

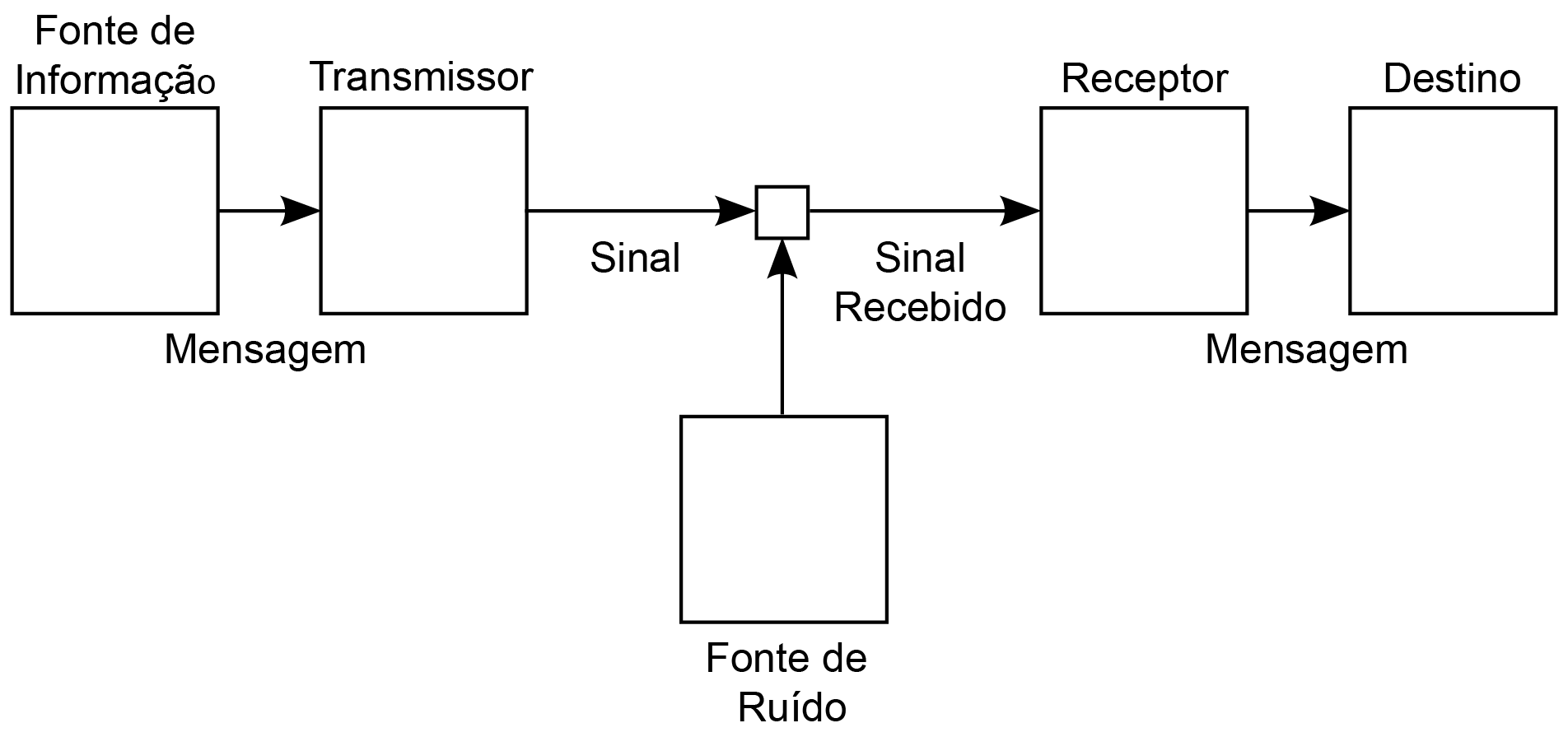

O interesse deste ensaio está no entendimento de como a noção mais hegemônica de informação é operacional no desastroso processo de dominação. Esta noção é oriunda da teoria da Shannon e da interpretação de Weaver124, e diz respeito ao problema de reproduzir uma mensagem com a maior fidelidade possível – na melhor das situações, reproduzir uma mensagem exatamente como foi originalmente emitida. Essa transmissão depende de alguns fatores:

A capacidade de transmissão ou armazenamento de mensagens de um meio.

A interferência, uma vez que a transmissão de mensagens pode sofrer adulterações intencionais ou não-intencionais, no espaço e no tempo e que alteram, limitam ou suprimem mensagens.

A teoria de Shannon-Weaver visa garantir que mensagens cheguem aos destinos da melhor maneira e no menor tempo possível. O truque consiste em ajustar o aparato de comunicação para que haja redundância suficiente nas mensagens – já que uma porção de mensagem adulterada pode se compensada por uma porção equivalente, mas não adulterada – porém sem que isso incorra numa diminuição excessiva da capacidade de transmissão: quanto maior a redundância, maior o tamanho da mensagem, e mais tempo demora para transmiti-la e recebê-la.

Figure 14.1: Diagrama da comunicação segundo a Teoria Matemática da Informação de Shannon (1948). Imagem via Wikimedia Commons e distribuída em Domínio Público.

Essa relação entre redundância e tamanho médios de mensagens é obtida pela escolha do processo de codificação no qual símbolos de um conjunto finito – ou alfabeto – original são convertidos em símbolos de outro alfabeto finito de transmissão.

Sendo finitos ambos os conjuntos de alfabetos, sempre há uma quantidade finita de mensagens de um dado tamanho que pode transmitida ou recebida.

Uma informação é uma seleção finita de símbolos no alfabeto original, e podemos entender como um processo de dar forma específica a uma sequência de símbolos anteriormente em estado de indeterminação.

Já uma mensagem é a codificação desta informação nos símbolos do alfabeto de transmissão.

Uma informação “shannoniana” de um dado tamanho consiste então no conjunto de escolhas de símbolos disponíveis no alfabeto original, e que pode ter um tamanho maior – mas nunca menor – quando codificadas no alfabeto de transmissão.

São essas quantidades de escolhas que são passíveis de medição. A menor medida de escolha conhecida é aquela referente à seleção entre duas possibilidades, ou escolha binária. Essa mínima unidade de escolha é a medida mais comum para a quantidade de informação, e recebe o nome de “bit” (binary digit, ou dígito binário)125. Bits basicamente medem a quantidade de escolhas binárias, ou bifurcações.

O processo inicial de codificação de uma medição para uma sequência de dígitos – em geral dígitos binários – é chamado de digitalização.

A quantidade de informação gerada por uma comunicação específica pode ser entendida como uma redução de todas as outras possibilidades de comunicação – ou seja, uma seleção específica de uma sequência de símbolos implica numa escolha de não selecionar qualquer uma das outras sequências em potencial. Quanto maior a quantidade de informação, menos uma mensagem pode ser “resumida” numa versão menor.

Analogamente, uma mensagem recebida pode ser entendida como uma redução de incerteza – cada mensagem que chega reduz a quantidade de informações em potencial que um receptor poderia receber.

A probabilidade de ocorrência de símbolos no alfabeto original depende da linguagem utilizada na composição mensagens, e alguns símbolos serão muito mais usados do que outros. A Tabela 14.1 mosta a ocorrência de símbolos numa versão deste ensaio. A depender do conjunto de textos amostrado, os valores resultantes são diferentes.

| Símbolo | Ocorrências | Frequência (%) | Símbolo | Ocorrências | Frequência (%) |

|---|---|---|---|---|---|

| e | 38364 | 11,8026 | x | 1242 | 0,3821 |

| a | 37475 | 11,5291 | y | 1210 | 0,3723 |

| o | 32472 | 9,9899 | z | 1062 | 0,3267 |

| s | 25273 | 7,7752 | j | 887 | 0,2729 |

| i | 24701 | 7,5992 | í | 877 | 0,2698 |

| r | 20971 | 6,4517 | ó | 857 | 0,2637 |

| n | 19961 | 6,1409 | w | 811 | 0,2495 |

| t | 19782 | 6,0859 | ê | 476 | 0,1464 |

| d | 15973 | 4,9140 | k | 434 | 0,1335 |

| m | 15396 | 4,7365 | õ | 376 | 0,1157 |

| c | 13336 | 4,1028 | ú | 257 | 0,0791 |

| u | 11155 | 3,4318 | â | 147 | 0,0452 |

| l | 10600 | 3,2611 | à | 147 | 0,0452 |

| p | 9181 | 2,8245 | ô | 110 | 0,0338 |

| f | 5251 | 1,6155 | ō | 60 | 0,0185 |

| g | 4527 | 1,3927 | ñ | 9 | 0,0028 |

| h | 3710 | 1,1414 | ü | 8 | 0,0025 |

| v | 3486 | 1,0725 | ā | 8 | 0,0025 |

| b | 3272 | 1,0066 | è | 6 | 0,0018 |

| ã | 2696 | 0,8294 | ē | 5 | 0,0015 |

| q | 2482 | 0,7636 | ī | 2 | 0,0006 |

| ç | 2210 | 0,6799 | ä | 2 | 0,0006 |

| é | 1468 | 0,4516 | ṇ | 1 | 0,0003 |

| á | 1306 | 0,4018 | Total | 334042 | 100 |

Codificações eficientes usam uma quantidade menor de símbolos no alfabeto de transmissão para símbolos mais prováveis no alfabeto original, deixando uma quantidade maior de símbolos de transmissão para símbolos originais com menor ocorrência.

Em muitas comunicações, a probabilidade de que o próximo símbolo de uma sequência depende de quais foram os símbolos recebidos anteriormente: há uma redundância inerente na composição de mensagens no alfabeto original. Quanto maior essa redundância, menor é a informação efetiva contida numa sequência de símbolos do alfabeto original. Por outro lado, quanto menor for a redundância na sequência original, isto é, quanto mais a sequência original for aleatória, maior a quantidade efetiva de informação. À quantidade efetiva de informação contida numa sequência de símbolos do alfabeto original é dada o nome de entropia informacional126. Quanto maior essa entropia, menos correlação interna existe numa mensagem, e menos ela é “compressível”, isto é, resumível numa mensagem menor.

A medida de informação shannoniana não diz nada a respeito da qualidade da informação, e nesse sentido ela seria “agnóstica” a qualquer avaliação de valor, utilidade, veracidade, factualidade, plausibilidade etc. Ela ignora completamente etapas da comunicação como a intencionalidade e a interpretação. De tal modo que ela é aderente a qualquer comunicação que possa ser de alguma maneira reduzida ao esquema de codificação acima descrito127.

Mesmo que isto se aplicasse a qualquer forma de comunicação humana, não há como determinar a quantidade de informação, no sentido shannoniano, já produzida pela humanidade. Primeiramente seria necessário explicitar de que quantidade de informação shannoniana estamos nos referindo. Seriam todas as palavras que já foram pronunciadas, de tudo o que já foi escrito ou de qualquer ato humano que poderia ter sido registrado de algum momento – incluindo aí registros arqueológicos e fósseis de todos os antepassados hominídeos? E disto tudo, como determinar aquilo que já foi perdido, considerando que muitas perdas não foram sequer notadas, muito menos contabilizadas?

References

Shannon e Weaver (1963). Não é a intenção aqui em detalhar a teoria shannoniana da informação, mas apenas fazer um breve resumo, pontuar alguns elementos e tentar definir os conceitos de uma maneira um pouco menos evasiva e indefinida tal como apresentados por Shannon e Weaver. As críticas à teoria shannoniana aqui colocadas não são dirigidas especificamente a Claude Shannon, que parece ter sido uma pessoa bem interessante, mas sim a processos sociotécnicos hegemônicos amparados pela metrificação informacional.↩︎

A palavra inglesa bit também alude a “pedaço” de informação, agora dividida em partes tão pequenas quanto possível. Alternativamente, poderíamos usar uma medida um pouco mais vaga porém talvez mais fácil de compreender: a quantidade de palavras numa mensagem, porém não há uma relação definida entre a quantidade de palavras em qualquer linguagem e a quantidade de bits (ou escolhas binárias) necessária para codificá-las.↩︎

Pretendemos tratar e re-des-construir o conceito de Entropia e suas relações com Informação num outro estudo.↩︎

Diria até que tudo o que não está codificado desta maneira, ou que não seja passível desse tipo de codificação, não é informação no sentido shannoniano, nem pode assim ser informatizado. Um informacionalista provavelmente retrucaria, dizendo que tudo já está codificado de alguma maneira, só depende de descobrirmos quais são os alfabetos utilizados, o que acaba por recair numa doutrinação das formas.↩︎